L’éducation à l’ère de l’intelligence artificielle

L’IA fait aujourd’hui irruption dans les milieux éducatifs. Avec, à la clé, de nouvelles perspectives d’enseignement et d’apprentissage, mais aussi de nombreuses interrogations sur la pertinence de ses usages pédagogiques.

Une enquête de Kassiopée Toscas - Publié le

L’enseignement bousculé par l’IA

L’IA entre résolument à l’école, en France comme ailleurs. Depuis trois ans, des applications « intelligentes » d’apprentissage du français (Lalilo, Navi) et des mathématiques (Adaptiv’maths, Mathia et Smart Enseigno) sont déployées en CP, CE1 et CE2. En 2024, l’IA devrait faire sa rentrée au lycée avec l’application de révision Mia Seconde disponible sur tablette et smartphone et destinée, selon les termes ministériels, à « relever le niveau des élèves ».

Sur fond de course à l’innovation et de numérisation croissante de l’éducation accélérée par la pandémie de Covid-19, l’IA est ainsi présentée comme une solution aux inégalités sociales d’apprentissage et aux baisses de performance signalées année après année par les enquêtes PISA (Programme international pour le suivi des acquis des élèves). Son principal atout, pour ses promoteurs : des exercices et un suivi personnalisés. Mais cette promesse ne sera pas nécessairement tenue, alertent les chercheurs en sciences de l’éducation.

La mise en ligne de l’IA générative ChatGPT a quant à elle suscité de vives réactions de la part des enseignants, qui redoutent que cela dispense les élèves de penser par eux-mêmes. Selon une étude de mai 2023 menée en France auprès d’usagers de Yubo âgés de 13 à 25 ans, un jeune sur cinq utiliserait d’ailleurs ChatGPT pour ses devoirs scolaires ou universitaires.

L’IA générative pose ainsi plusieurs défis inédits aux systèmes éducatifs. Pratiques et pédagogiques, mais éthiques également : confidentialité des données des élèves, traitement des biais et stéréotypes charriés par les algorithmes.

L’Unesco tire la sonnette d’alarme

En septembre 2023, l’Unesco publie le premier guide mondial sur l’intégration de l’IA en milieu scolaire, préconisant l’adoption de normes pour la protection des données et le recours aux IA génératives en classe à partir de 13 ans seulement ; aujourd’hui, moins de 10 % des écoles et universités encadreraient son utilisation. L’organisation alerte aussi sur la précipitation avec laquelle les applications sont déployées, pour des motifs avant tout économiques et en l’absence de contrôle ou de réglementation. Le marché de l’IA éducative est d’ailleurs en plein essor, avec un chiffre d’affaires mondial estimé à 4,3 milliards d’euros en 2024 et un quadruplement attendu d’ici 2032.

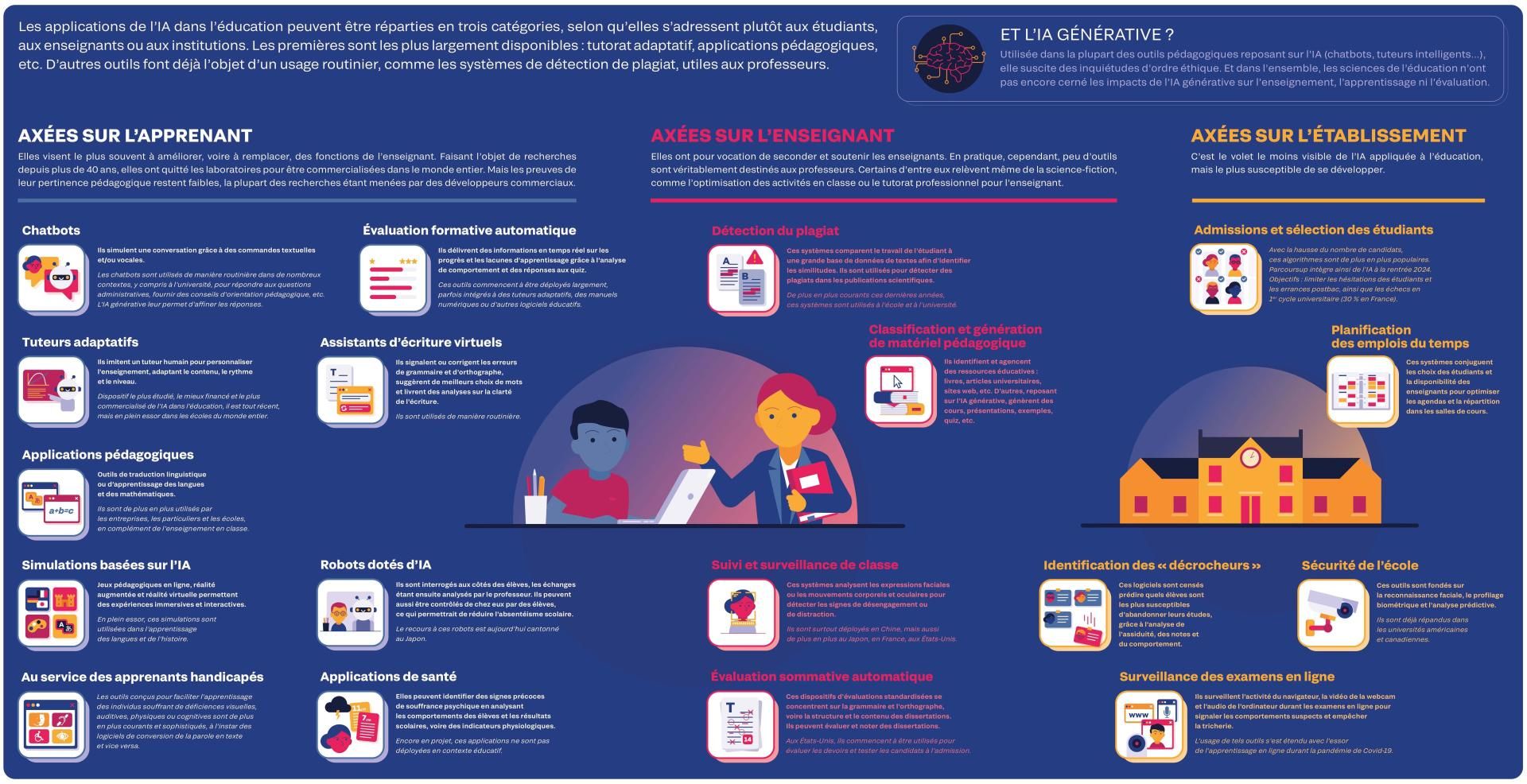

Les applications de l'IA dans l'éducation

Une manière de réduire les inégalités scolaires ?

Une des vertus de l’IA en contexte éducatif est le développement de matériel pédagogique inclusif, qui intègre des technologies d’assistance aux élèves en situation de handicap, comme la transcription de la parole pour aider les malentendants ou la lecture audio de l’écran pour accompagner les malvoyants.

Dans les pays en développement, l’IA est aussi utilisée pour réduire l’écart d’alphabétisation entre les élèves à revenus faibles et élevés. Ainsi, le programme « Letrus » au Brésil, centré sur l’apprentissage de l’écriture, bénéficie à près de 200 000 élèves et étudiants. En Afrique subsaharienne, où les EdTech (« technologies de l’éducation ») sont déjà très présentes, le recours à l’IA permet encore de pallier le manque de formation des enseignants, à l’instar du chatbot Teacher.AI en Sierra Leone.

Si elles peuvent réduire les inégalités d’accès à l’éducation, ces solutions risquent cependant d’en exacerber d’autres, comme la nouvelle « fracture numérique » : non plus la disponibilité matérielle des technologies, désormais courante, mais l’éducation familiale au numérique, très inégale selon les milieux sociaux. Or, comme la surexposition aux écrans, un recours délétère à l’IA - par exemple un manque de distance critique vis-à-vis des algorithmes - pénalise aussi les plus défavorisés.

Enfin, les outils pédagogiques commercialisés à ce jour reposent sur des algorithmes qui n’ont pas été conçus à des fins éducatives : de grands modèles de langage, le plus souvent américains, entraînés à partir de données reflétant les normes culturelles occidentales et comportant des biais sociaux, raciaux et de genre. Ils risquent donc d’aggraver les préjugés existants à travers les contenus enseignés ou les systèmes d’identification des « décrocheurs ».

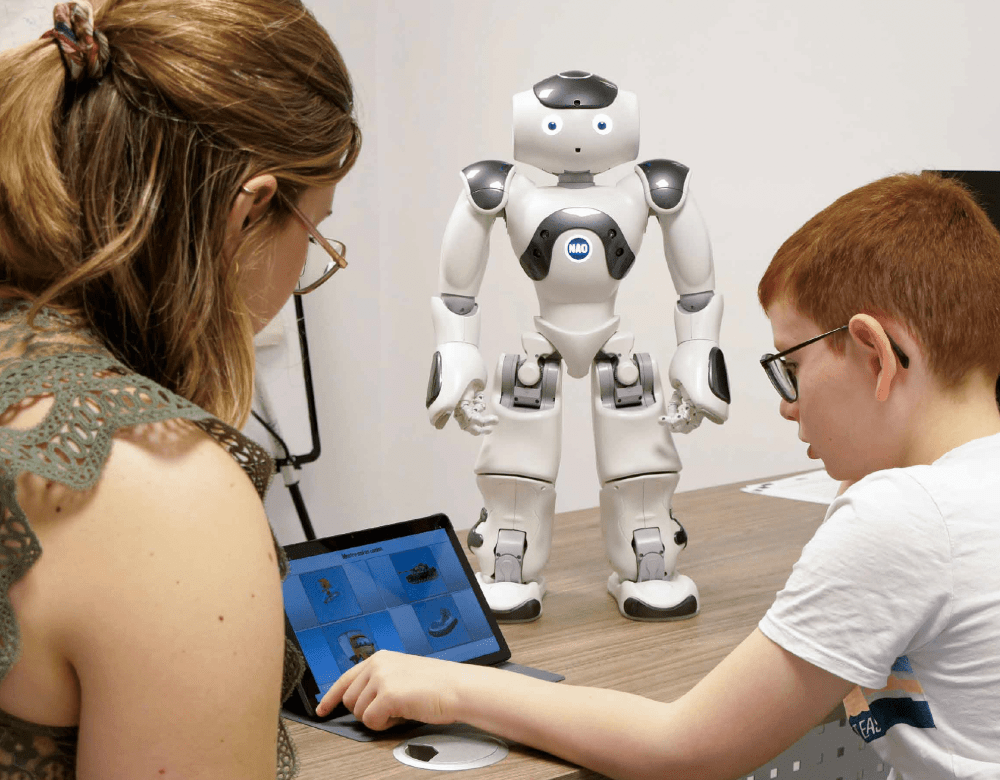

Des robots aux côtés des élèves autistes

Des robots assistés par IA pour améliorer l’attention d’enfants atteints de troubles du spectre autistique (TSA), leur compréhension des consignes et leurs compétences sociales : c’est l’objet d’une expérience de robotique sociale menée depuis trois ans à Nancy par l’association Jean-Baptiste Thiéry en lien avec l’université de Lorraine. En dehors des cas de déficience intellectuelle sévère, ces enfants interagiraient en effet plus aisément avec un robot, au comportement plus prévisible qu’un être humain. Mieux : les compétences acquises se transfèrent dans les interactions sociales, en particulier dans le domaine de la communication.

La personnalisation au cœur des débats

La promesse centrale de l’IA est la personnalisation des apprentissages. Une foule de plateformes de tutorat adaptatif proposent ainsi des parcours sur mesure avec un calendrier, des cours, des exercices et des évaluations individualisés. Mirage « techno-solutionniste » dénoncé par des sociologues, alors que les écoles ont surtout besoin de davantage de moyens humains ?

Les sciences de l’éducation rappellent qu’il s’agit là d’une promesse ancienne et à la portée limitée : l’approche adaptative repose à ce jour sur les seuls critères de performance. Elle risque ainsi d’engendrer un cercle vicieux et d’aggraver les inégalités culturelles : un élève n’ayant pas confiance en lui traite les tâches plus lentement et se voit proposer par l’algorithme des tâches plus simples.

En outre, les outils actuellement disponibles ne personnalisent pas réellement les exercices : ils se contentent de classer les élèves en référence à des parcours types. Et tendent ainsi davantage à standardiser les apprentissages… qu’à les individualiser ! En réduisant l’éducation à une série de tests et de résultats mesurables, comme si apprendre consistait à accumuler des informations, ces outils risquent aussi de privilégier les matières les plus quantifiables et de négliger la dimension collective et sociale de l’enseignement, et les besoins individuels des apprenants. La recherche publique s’efforce donc de concevoir des IA éthiques qui accompagnent l’apprenant à sa demande, dans le cadre d’un dialogue explicite, au lieu de l’orienter automatiquement et de baliser son parcours en préjugeant de ses choix et de son niveau.

Un compagnon d’apprentissage éthique

À l’université de Lorraine, un projet pionnier lancé il y a trois ans vise à développer un compagnon d’apprentissage conforme aux principes d’une IA éthique : respectueux des informations personnelles, non discriminant, transparent et placé explicitement sous contrôle humain. Les données d’apprentissage de l’algorithme sont soigneusement sélectionnées en amont : un changement radical, car les modèles de langage comme ChatGPT sont entraînés sur des corpus textuels considérables, sans distinction de provenance ni de qualité. Autre nouveauté : l’entraînement de ce compagnon baptisé 3PEN s’effectue en interaction avec l’usager, par confrontation progressive à ses réactions.

Un soutien pour les enseignants ?

L’IA est souvent présentée comme une aide utile aux enseignants, car la plupart des applications sont censées accomplir une partie de leurs missions : organisation des activités, conception des cours, évaluation des copies... L’IA permettrait aussi d’automatiser les tâches fastidieuses, administratives ou pédagogiques comme la notation. Dans les faits, cette promesse de gain de temps, brandie depuis l’existence des premiers outils numériques, est rarement tenue : faute de formation, le recours à ces outils a plutôt entraîné à ce jour… une hausse du temps de travail.

Cela étant, plusieurs outils peuvent se révéler précieux, à l’instar des logiciels anti-plagiat, amenés à se perfectionner avec les versions successives de ChatGPT. Les modèles génératifs peuvent aussi aider à rédiger des cours, des diaporamas ou des quizz. Une étude américaine a ainsi révélé que 50 % des enseignants utilisaient déjà ChatGPT dans leur cadre professionnel, dont 10% quotidiennement !

Dans tous les cas, l’outil doit bel et bien accompagner l’enseignant, et non le remplacer. Certes, l’IA peut contribuer à la conception des cours, mais c’est l’enseignant qui fixe les objectifs pédagogiques et contrôle les contenus, car les données alimentant la plupart des algorithmes ne sont ni fiables ni récentes. C’est lui aussi qui explicite des raisonnements que les algorithmes ne livrent pas toujours, leurs mécanismes internes restant une « boîte noire » jusque pour leurs concepteurs. En attendant des modèles transparents, l’IA générative constitue une belle opportunité d’aiguiser l’esprit critique des jeunes, en leur demandant par exemple d’identifier les limites et les biais de ChatGPT. À l’université, certains professeurs utilisent d’ailleurs déjà ChatGPT en ce sens.

Une banale histoire d’innovation ?

Certaines révolutions techniques ont bousculé les méthodes pédagogiques, comme l’imprimerie, qui a favorisé la lecture et l’écriture, ou le stylo-bille et la calculatrice, qui ont rendu obsolètes la calligraphie et le calcul mental. D’autres ont échoué à s’intégrer aux pratiques pédagogiques, à l’instar de la télévision scolaire des années 1970 ou des premiers micro-ordinateurs : ces outils dépossédaient les professeurs de leur rôle de meneur de jeu. Ce bref regard en arrière suggère qu’une innovation est plus susceptible d’être adoptée si elle respecte l’autorité de l’enseignant et son monopole sur la transmission du savoir.

Quelle école pour demain ?

Si l’on se fie à l’histoire, il est probable que l’IA s’insère dans le système éducatif sans remettre en cause son principe fondateur : la relation professeur-élèves. Cela dit, des chercheurs redoutent que le recours aux outils numériques « intelligents » ne permette de réduire le nombre d’enseignants.

Une chose est d’ores et déjà certaine : les apprentissages seront bouleversés. Ainsi, une nouvelle discipline voit le jour : l’éducation au fonctionnement et à l’utilisation de l’IA, comme la rédaction de requêtes claires et non biaisées (les fameux prompts). En outre, l’IA pourrait favoriser l’apprentissage collaboratif – en facilitant la formation de communautés ou de groupes de travail – ou remplacer les examens de fin d’année par une évaluation continue, plus juste, des élèves, grâce à des dispositifs de suivi de leurs progrès. Au-delà, des compagnons personnalisés pourraient accompagner les individus même après leur insertion professionnelle, pour un apprentissage tout au long de la vie.

Enfin, l’IA invite à repenser les pratiques éducatives en faisant la part belle à l’exercice de l’esprit critique plutôt qu’à la mémorisation ; et à une évaluation fondée sur le raisonnement plutôt que sur le résultat. Les plus optimistes présagent même que l’IA contribuera à mobiliser certaines des qualités humaines les plus nobles : le sens critique, la sensibilité, l’imagination ou l’intuition. Mais pour cela, il faudra enseigner à tous comment utiliser l’IA à bon escient : en s’émancipant, et non en s’enfermant dans une reproduction du monde.

Quels impacts sur le cerveau ?

Les capacités de réflexion des élèves risquent-elles de s’atrophier à force d’être déléguées aux machines ? Un mythe, selon certains chercheurs, qui ne constatent pas de dégradation des performances, mais plutôt une flexibilité cognitive accrue des jeunes. Pour eux, déléguer des tâches à l’IA redistribuera simplement nos facultés cérébrales, au bénéfice de l’esprit critique et la réflexion. Mais d’autres chercheurs craignent que ces outils ne formatent notre pensée en court-circuitant le processus d’apprentissage et en offrant des solutions standard, comme avec les suggestions automatiques d’écriture. Ici aussi, tout dépendra des usages et des modalités d’intégration dans la pédagogie.

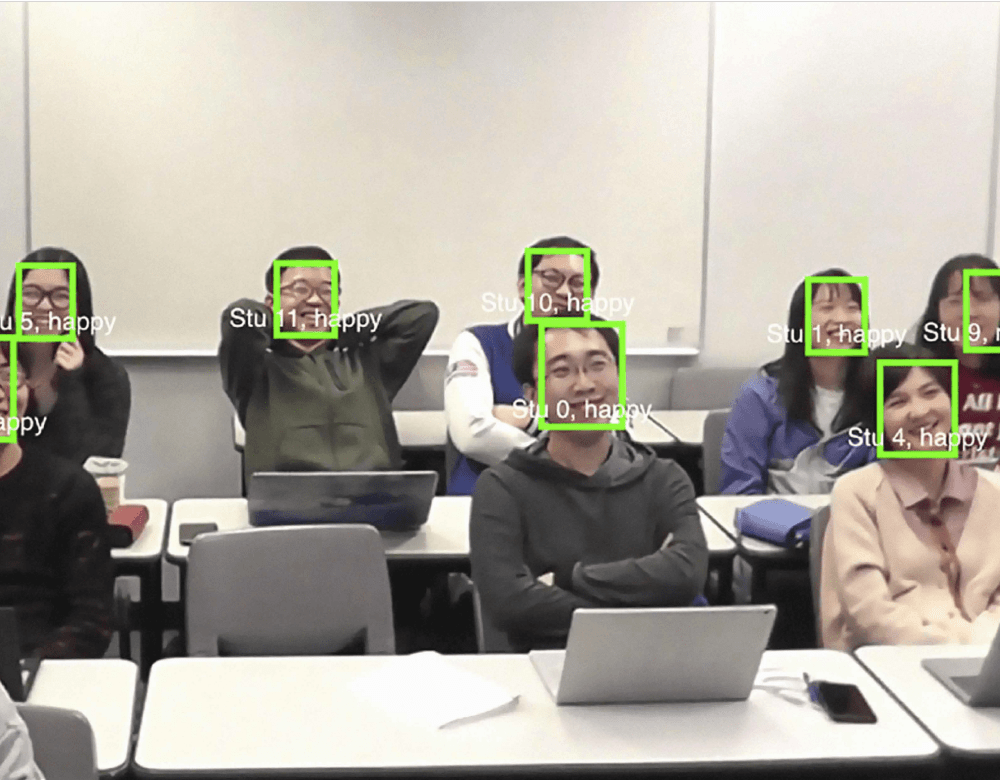

Émotions et suivi en temps réel

Des écoles chinoises utilisent déjà caméras, microphones, voire capteurs physiologiques, pour analyser les émotions des élèves, détecter leurs baisses d’attention et en notifier le professeur et les parents. Mais ce phénomène dystopique n’est pas l’apanage de la Chine : les logiciels de surveillance émotionnelle sont de plus en plus utilisés en contexte éducatif, parfois intégrés à des tuteurs en ligne. Aux États-Unis, l’appli SpotterEDU a été testée dans plusieurs universités, suscitant d’ailleurs de vives critiques. L’idée : suivre l’assistance aux cours et envoyer des mails automatiques aux enseignants ou à l’administration en cas de retard ou d’absence d’un étudiant.